道高一尺魔高一丈 AI助力“深伪”难辨

字体大小:

- 小

- 中

- 大

在AI时代,透过深伪技术已可做到“换脸”和“换声”,许多公众人物成了仿造目标。记者通过访问技术研发者,了解深伪视频和音频的制作过程,以及如何辨别真伪。也看到深伪技术正面之处。

常言道,“有图有真相”,但在AI时代,这句话似乎要打上一个问号。随着内容生成技术成熟普遍,基于深度学习与影音合成的深度伪造(简称“深伪”,deepfake)也愈发真假难辨。公众人物成了深伪技术的主要目标对象,近来YouTube弹窗经常出现打着名人效应旗号的广告,推荐理财产品。

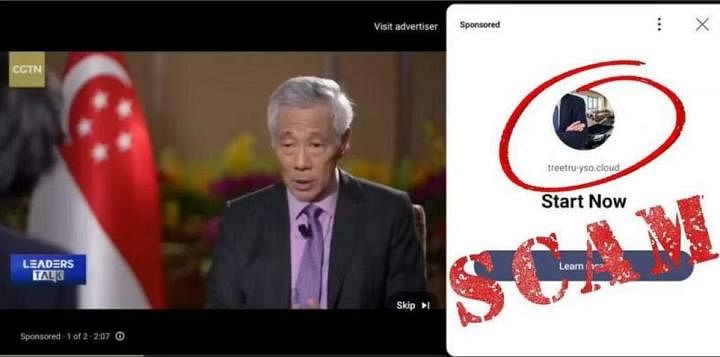

不久前,不法分子利用深伪技术窜改李显龙总理的访谈片段,宣传加密货币骗局。总理在脸书帖文,呼吁公众提高警惕,切勿上当受骗。也有仿造CNA新闻播报关于淡马锡控股发布的一款新基金,鼓励公众购买。一系列近乎逼真的视频,乍一看难辨真假,回过神来才有警觉这可能是一种新兴的仿造技术。

深伪技术Deepfake早在2014年问世,2017年随着一款可以换脸的影片制作软件走入大众视野。踏入AI时代,深伪技术已经可以做到“换脸”和“换声”,这就意味着写好“剧本”后,可以将任何话放在任何人口中。不仅在本地,而是全球范围内,利用深伪技术制造假消息的例子屡见不鲜,公众人物如马斯克、奥巴马、普京等,都成为被深伪的对象。

记者通过访问技术研发者,了解深伪视频和音频的制作过程,以及如何辨别真伪。揭开数字骗局的面纱,只有“知彼”了解deepfake的传播特点,才能提高警觉,避免上当受骗。

一张图就能换脸

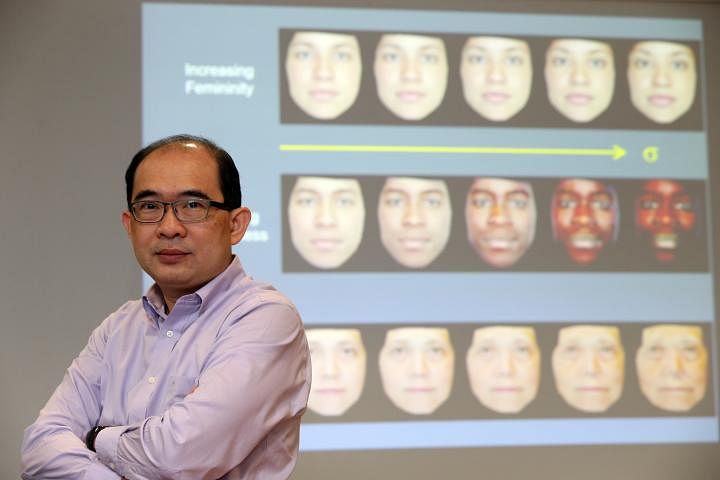

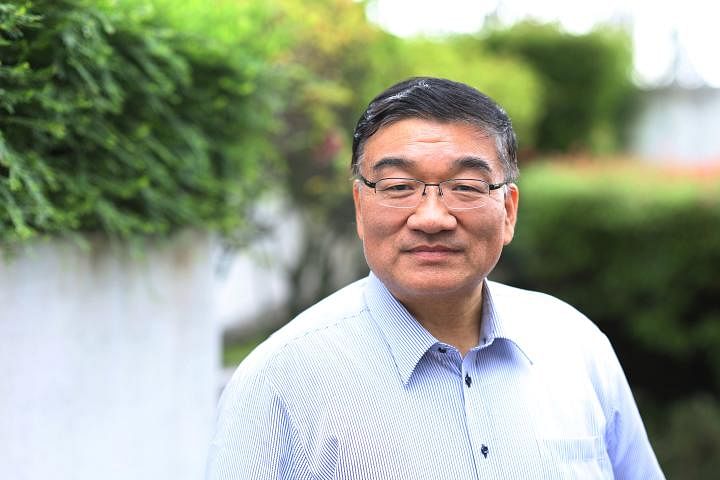

国大电脑学院(电脑科学系)副教授沈茂祯,从2019年开始研究视频深伪技术。他介绍说,制作深伪视频需要的两大元素分别是,目标对象的源图像(source image),以及一段驱动视频(driving video)。譬如要仿造一段奥巴马的视频,首先需要为机器学习提供参照物,源图像可以是奥巴马的照片或影像资料,让机器“记住”这张脸之后,还需要一段主导面部动作等的驱动视频。在做好的程序中,任何人都可以成为驱动视频中的“演员”负责做动作,读稿讲话,最终出来的效果是被换脸成奥巴马在讲话。

当被问及需要多少源图像作为学习数据时,沈教授说随着技术日益发展成熟,一张图就可以做深伪处理。例如两人在视讯时,当即截屏一张对方的照片,就可以用作源图像。社交媒体年代,个人照在网上唾手可得,拿到一张照片“贴在”制作好的视频中,利用音频深伪技术换成模仿目标人物的声音,音频、音调、音色都能做到如假包换,整个视频看起来就像是目标人物在讲话。

如果要视频做得更逼真,就需要大量收集素材。对于网上出现的李显龙总理的视频,沈茂祯分析,从视频的时长看,制作者收集了大量总理的“图像数据”,录好讲话内容后调成总理的音色发布上网。“因为公众人物的视频和影像资料足够丰富,通常会成为深伪的目标人群,如政治任务、明星等曝光率高,也容易从网上搜集到素材。”

被篡改的声音

在深伪技术领域也有细分,有人专攻视频,有人专做音频。弗劳恩霍夫应用与集成安全研究所(Frauenhofer AISEC) 是德国一家世界领先的网络安全应用研究机构,在本地与南洋理工大学有合作。尼古拉斯·穆勒(Nicolas Müller)是该机构研究员,与其团队目前在德国主要负责研究深伪音频(audio deepfake)。在视讯访问中,穆勒分享深伪骗局在德国的情况:不少年长者会收到孩子发来的求助电话,称自己遇到麻烦需要钱救急,声音的逼真程度足以骗过亲生父母。也有雇员收到雇主的语音短信,要求对方转账到某账户。或是通过社媒发布伪造的政治家言论,希望赚取点击量。

深伪技术建立在神经网络(neural network)的人工智能算法上,是一种机器深度学习的过程,用于教电脑以受人脑启发的方式处理数据,类似于人脑的分层结构中的互连节点或神经元,创建适应系统,让电脑可以从错误中学习并不断改进。建立AI神经网络是一种大数据主导的学习方式,在训练机器学习时“投喂”大量数据,机器会自动抓取声音中有特色的部分加以复刻。穆勒类比道,就好像善于模仿声音的人,只要听一两分钟就能模仿出对方的声音,AI也像这样,向它“投喂”名人政客的声音,它或抓取模仿人说话的语音、语调、语速等。

穆勒介绍目前机构推出两大网站,帮助公众鉴别deepfake。其一是用来鉴别视频中的音频内容是否伪造,只要复制YouTube链接或上传视频文件,系统就会帮忙分析。另一个是类似“试听练耳”的网站,点击播放音频判断真假,平日里多练习可以帮助提升听觉辨识力。记者尝试做了20道听力题,正确率是16/20,有些音频使用人声后真假难辨。

对于深伪技术的未来发展,穆勒认为随着这项技术愈发触手可及,可以用十分便宜的价格制造出高品质深伪音频。从社会层面来说,他认为人们需要学习如何有效辨识处理深伪信息,例如收到可疑求救电话,可以先挂断再打回给本人核实是否是真人来电。此外在于培养警觉意识,“不能轻易相信一张照片,因为可能被photoshop修改过,也不能轻易相信一把声音,因为可能被深伪技术编辑过。”

三招辨别深伪视频

既然如此,我们可以如何鉴别深伪信息?沈茂祯认为,可以通过物理假象(physical artefacts)、语义特征(semantic features)和内容(content)三方面来鉴别。

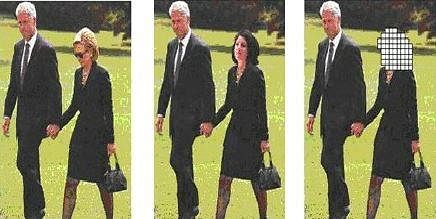

物理假象包括视觉瑕疵,如虚假图像和真实图像之间的接缝混杂不清,出现色彩闪烁。语义特性包括渲染不合理的部分,如不匹配的眼睛,畸形的五官,面部与头部姿势的错位,或与视频情感内容不符的表情。在内容上,通过常识性的逻辑分析,看看被报道的人是否有可能说或者做正在报道的事,例如乔布斯作为iPhone创始人不可能推销三星手机。

从受众心理角度分析,团队正在进行的一项研究发现,人们对人工智能生成的假新闻反应各不相同,这取决于资讯的呈现方式。 当AI生成的新闻配以文字、图片、视频相结合,并以社交媒体帖子的形式呈现时,人们会更加警觉。然而,当新闻仅由文字形式,人们的敏锐度和警觉性往往较低( “敏锐度”或“警觉性”是指人们区分人工智能生成内容,以及非人工智能生成内容的能力)。

以人群为变量,研究团队从美国、印度和新加坡,各邀请约200名参与者进行对比 。与印度和美国参与者相比,新加坡参与者表现出稍高的敏锐度。男性和对AI技术有所了解的人,更有可能认为新闻是由AI制作的。

视频为主流内容或须加以标示

从媒介传播学角度分析,北京师范大学新闻传播学院教授喻国明认为,深伪技术的产生与视频内容主流化有着密切关系。其团队近期的研究发现,网络内容中原本主流的文字表达已经压缩到20%,而视频表达已占据80%,“这本身是一种表达形态的重心转移。文字表达相对干净、确定、严谨,视频的特点是比较感性,表达元素丰富,当然也可以说比较离散凌乱,尤其像使用蒙太奇切割手法容易造成逻辑中断等。视频表达会对人们的思想产生影响,如短链思考,感性认知,以及注重表面效应。”

通过信息分类的方式标注预警,一方面是将信息分类成不实信息、谣言信息。另一方面,是将人群分为易感人群、非易感人群。通过提供色彩标注等方式,帮助在深伪信息方面辨别能力比较弱的易感人群,比如说加上黄色标注就说明信息来源是单一的,要对它保持警惕。加以橙色,代表不同人对这则消息有不同意见,虽然不能证实是谣言伪论,但存有争议。用标注的方式提供给读者提示。

从条例与技术入手

随着AI技术的发展,目前各国都在草拟对于内容生成的管制条例。我国人工智能验证基金会(AI Verify Foundation)和资讯通信媒体发展局(IMDA),在1月16日提出生成式人工智能(Generative AI)治理框架草案,并向国内外征求意见,希望探讨采用“营养标签”,让人们像了解食材那样可掌握各种人工智能模型的“成分”,使用时更安全放心。

澳大利亚于2023年发布了一项关于打击错误信息和虚假信息的法案草案,引起激烈讨论,其中就包括不实信息的部分。欧盟的《数字服务法案》在日前生效,英国则通过了新的《网络安全法案》。在AI时代初期,不同国家都在努力解决如何处理网路上合法但有害内容的问题,并寻求国际间的合作。

沈茂祯从技术层面分享,目前业界普遍探讨的两大数字水印技术——易损数字水印(Fragile watermarking)和鲁棒数字水印(Robust watermarking),或许会在deepfake横行的时代得到广泛应用。两种皆为隐形的水印技术,易损数字水印是指在生产多媒体内容的过程中,一旦多媒体数据(视频、音频等)遭到修改,内嵌的数字水印就会被破坏,如有篡改可以在后端看到改动发生的位置和改动程度。相反的,鲁棒数字水印是无法被更改的,在一些常规图像处理(如压缩、滤波、去噪)和恶意攻击下依然存在。好像是内容生产者的标记,就算是被人篡改盗用,水印依然存在,好证明生产者是谁。

硬币另一面 Deepfakes的正面应用

看向硬币的另一面,任何技术的存在都可以是一把双刃剑,主要看使用者如何使用,深伪技术也是如此。落入不法者手中,它就成了制造假消息的工具,落入有心者手中,它可以成为造福人的工具,带来正面应用。

以音频深伪技术为例,一家名为VocaliD的公司,为失语者提供语言辅助工具,让他们可以“开口讲话”。该线上平台开放给所有人,可以通过录制自己大声朗读的内容将声音“捐献”给VocaliD的语音库。目前平台已收集了全球各个地区不同年龄层、不同人种的声音,失语者可以通过设定好的程序设备,挑选自己喜欢的音色作为自己的“发声器”,用被赋予了身份认同的声音和家人朋友沟通。

沈茂祯介绍,类似于deepfake的换脸技术,一直以来都有在电影制作中使用,譬如在汤姆·汉克斯主演的《阿甘正传》中,有一幕主角与已故美国总统肯尼迪握手,使用数字虚拟技术完成了“穿越”。在《速度与激情》的拍摄过程中,主角保罗·沃克不幸离世,后期以数字虚拟人的技术,完成了整部电影的“换脸”重制。应用在教育领域,沈茂祯认为也有巨大的开发潜力,例如运用深伪技术重现历史,让历史人物从书本中“重出江湖”,活灵活现地出现在大众面前,还能通过视频与音频的结合实现对话。

No comments:

Post a Comment